在4月16日举行的百度开发者大会上,百度创始人、董事长兼首席执行官李彦宏宣布百度已训练出了Apollo视觉感知大模型,并表示视觉

为什么视觉大模型最大的应用场景是自动驾驶,视觉大模型是如何在自动驾驶中应用的,优势又有哪些?

最大的应用场景是自动驾驶是因为视觉感知是自动驾驶的核心技术之一,相当于车辆的“眼睛”,为车辆提供对周围环境的全面

视觉大模型是基于深度学习算法的一种高级神经网络模型,主要用于图像识别、目标检测、语义分割等任务。

卷积神经网络(CNN)是视觉大模型的核心算法之一,作为一种专门用于处理图像的神经网络结构,它能够有效地提取图像中的特征,如边缘、纹理、形状等。目标检测算法(如Faster R-CNN、YOLO)能够在图像中准确地定位和识别不同类型的物体,并给出物体的边界框和类别标签。语义分割算法(如FCN、SegNet)能够对图像中的每个像素进行分类,从而实现对图像的精细化理解和分割。

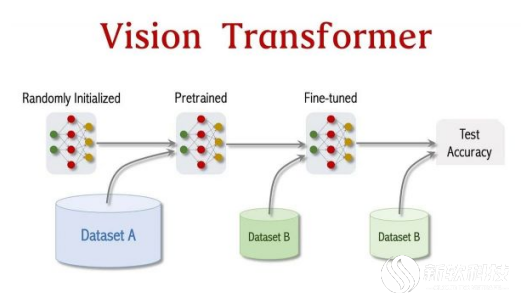

近年来,Transformer技术已成功应用于视觉领域,特别是在自动驾驶的视觉感知模型中,例如,Vision Transformer(ViT)通过期独特的自注意力机制,能够捕获图像中的长距离依赖关系,这对于理解复杂交通场景中各种元素如何互动尤为重要。此外,ViT可以有效转换2D图像特征到鸟瞰图(BEV),额外i自动驾驶车辆提供从上而下的环境感知视觉,大幅提升其全局建模能力和决策效率。

为了实现更全面的环境感知,视觉大模型还会融合来自不同传感器的数据,例如百度Apollo就利用多传感器数据进行感知融合,包括摄像头、激光雷达、毫米波雷达等。

视觉大模型在自动驾驶中扮演着关键的角色,主要应用于以下几个方面:

物体检测和识别:视觉大模型通过摄像头等传感器获取周围环境的图像信息,并对其进行处理和分析,识别和定位车辆、行人、交通标志、车道线等关键信息,为车辆的路径规划和决策控制提供基础。

例如,视觉感知大模型能够检测车道线,帮助车辆保持在车道内行驶;能够识别限速标志、红绿灯等,将信息传递给车辆控制系统,以便车辆做出相应的驾驶行为,遵守交通规则;同时基于目标检测算法,视觉大模型可以准确地检测并跟踪道路上的障碍物,如其他车辆、行人或动物,从而避免碰撞和发生事故。

道路分割与语义理解:通过语义分割算法,视觉大模型可以将道路图像分割成不同的区域,并理解每个区域的语义含义,例如识别车道、路边停车区域等。

深度估计:视觉大模型能够估计图像中每个像素的深度信息,从而构建周围环境的三维模型,为车辆提供更精确的距离感知能力。

行为预测与决策支持:视觉大模型可以预测其他交通参与者的行为,如预测行人的移动轨迹或其他车辆的驾驶意图,为自动驾驶系统的决策制定提供重要依据。

视觉大模型在自动驾驶中应用还具有独特优势:

首先是高精度感知能力,视觉大模型能够从海量数据中学习,具有强大的特征提取和模式识别能力,支持自动驾驶系统对周围环境的全面感知。

其次是端到端学习,视觉大模型可以通过端到端的学习方式,直接从原始图像数据中学习,无需人工设计特征和规则,简化了系统设计和数据处理流程。

然后是泛化能力强,在大规模数据集上训练的视觉大模型具有较强的泛化能力,能适应不同的天气、光照等环境变化,还能应对不同的道路场景。

最后是可扩展性强,视觉大模型可以不断学习新的数据,进行模型迭代和优化,提升感知能力和驾驶决策的准确性。

总的来说,视觉大模型在自动驾驶领域的应用前景广阔,随着算法的不断优化、算力的持续提升以及数据的快速积累,将会为智能交通带来更多可能性。